苏ICP备112451047180号-6

基于卷积神经网络的图像处理的设计

与本课题有关的国内外研究情况:

20世纪80年代,David Rumelhar和Geoffery E.Hinton等人提出反向传播(Back Propagation,BP)算法,解决了两层神经网络所需的复杂计算量并克服了异或问题。但受限于数据获取的瓶颈,神经网络只能在中小规模数据上训练,容易产生过拟合。

1998年,LeCun提出LeNet结构,用于解决手写数字识别的视觉任务。CNN最基本的架构被定义为:卷积层、池化层、全连接层。如今各大深度学习框架中所使用的LeNet都是简化改进的LeNet-5(-5表示具有5层)。受限于硬件,LeNet-5未能广泛应用。

2012年, AlexNet在ImageNet竞赛中以超过第二名10.9个百分点的绝对优势一举夺冠,从此深度学习和卷积神经网络名声鹊起,深度学习的研究如雨后春笋般出现。AlexNet为8层深度网络,其中5层卷积层和3层全连接层,不计LRN层和池化层,使用Relu激活函数加快收敛,dropout避免过拟合,LRN加速训练,GPU加速。

2013年ZF-Net获得ImageNet分类任务冠军,仅在AlexNet基础上调参,但性能提升不少。2014年ImageNet竞赛定位任务第一名和分类任务第二名为VGG-Nets,可看做加深的AlexNet,分类任务第一名为GoogleLeNet,其采用新思路,加深网络的同时也在网络结构上创新,引入Inception结构代替了单纯的卷积+激活的传统操作。

2015年何恺明推出的深度残余网络(ResNet)在ISLVRC和COCO上横扫所有选手。他在网络结构上做出创新,不再是简单的堆积函数,在深度学习发展历程上具有里程碑意义。2017年的DenseNet是一种密集链接的网络,其吸收ResNet精华部分,并作出创新,使得网络性能进一步提升。

本文构建AlexNet结构,并通过调参测试ZF-Net与VGG-Nets。

本课题研究的主要内容及方法:

研究内容:

1、为基于卷积神经网络的图像处理建立数学模型

2、设计实验方案

3、利用Matlab或Python等编程实现模型

4、基于若干数据集对所提模型进行准确率与时间性能评估

研究方法:

1.参考外文文献和中文资料,了解多任务学习、概念漂移、数据流、支持向量机等专业术语并对它们各自的研究方法(公式推导)进行探究。

2.学习使用Matlab或Python,学会建模与数据分析。

本课题所需要解决的问题:

1. 基于卷积神经网络的图像处理建立数学模型,较优数学模型的选择

2. 按照简单与特殊的监督式数据扩充方式的选择、数据预处理的实现、网络参数初始化的选择、激活函数的选择、损失函数的选择、网络正则化的训练、超参数设定和网络训练的实现、不平衡样本的处理方式、模型的集成方法进行算法设计

3.使用深度学习开源工具

4. 基于若干数据集对所提模型进行准确率与时间性能评估,实验数据的选择。

预期结果及其意义:

预期结果:

使用深度学习框架,构建小型的图像数据库,通过卷积神经网络对数据集进行训练分析,提取目标图像特征信息,最后对目标图像进行预测,与传统的图像分类算法进行对比,预测的准确率有很大的提升.

意义:

引入新的卷积神经网络结构有效提高图像识别的准确度,对比经典算法训练的参数有所减少,训练所需的时间更短,并具有良好的扩展性。

目录

第一章 绪论 1

1.1 课题的背景和意义 1

1.2 国内外研究现状 2

1.3 论文主要研究安排 2

1.4 论文章节结构安排 3

第二章 神经网络 4

2.1 逻辑回归 4

2.1.1 Sigmoid激活函数 4

2.1.2 交叉熵损失函数 5

2.1.3 逻辑回归的梯度下降 6

2.1.4 逻辑回归实例 7

2.2 神经网络 9

2.2.1 ReLU函数 10

2.2.2 Softmax回归函数 11

2.2.3 神经网络实例 12

2.3 深度神经网络 16

2.4 本章小结 17

第三章 卷积神经网络 18

3.1 CNN基础 18

3.1.1 输入层 18

3.1.2 卷积层 19

3.1.3 池化层 23

3.1.4 三维卷积 23

3.1.5 全连接层 23

3.2 CNN实例 24

3.3 CNN经典模型 26

3.4 本章小结 28

第四章 神经网络优化及机器学习策略 29

4.1 神经网络优化 29

4.1.1 归一化输入 29

4.1.2 参数初始化 31

4.1.3 Mini-Batch选择 32

4.1.4 Batch归一化 32

4.1.5 正则化 33

4.2 机器学习策略 35

4.2.1 迁移学习 35

4.2.2 数据集的划分 35

4.2.2 各类问题处理策略 36

4.3 本章小结 37

第五章 卷积神经网络的实施及测试 38

5.1 开发工具 38

5.1.1 Anaconda开源包管理器 38

5.1.2 深度学习框架TensorFlow 38

5.2 卷积神经网络的实现 39

5.2.1 数据准备 40

5.2.2 网络搭建 41

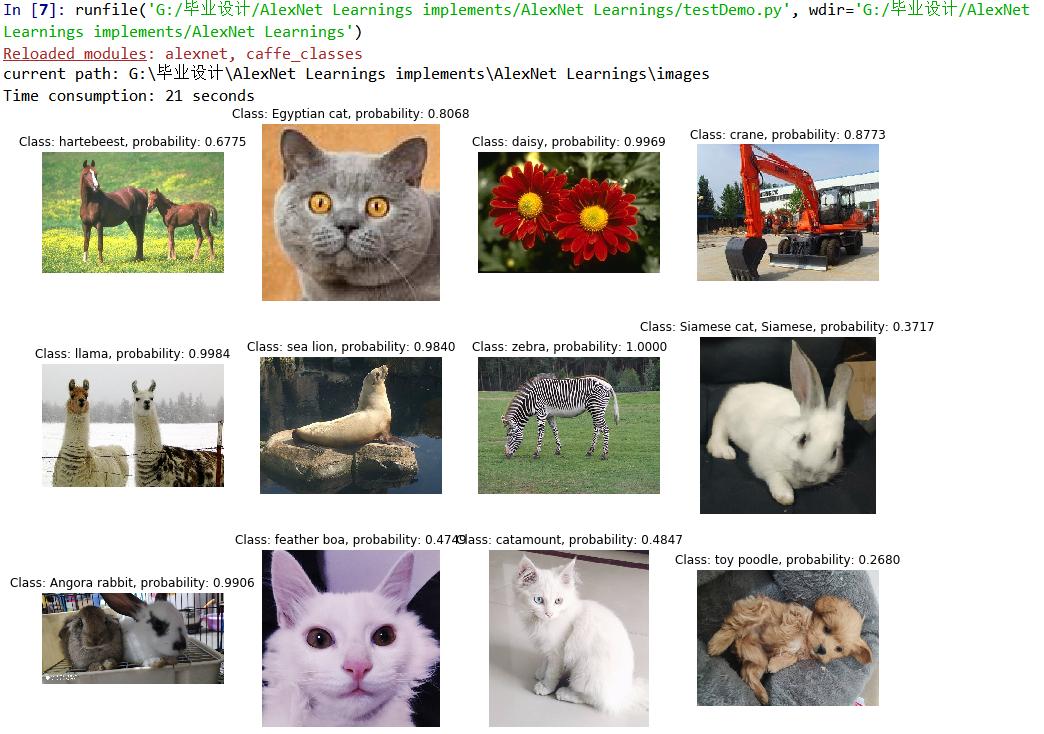

5.2.3 测试 44

5.3 卷积神经网络的迁移学习 45

5.3.1 迁移学习实施 46

5.3.2 测试 50

5.4 本章小结 50

总结与展望 51

致 谢 52

参考文献 53

第一章 绪论

1.1 课题的背景和意义

在当下的生活中,每天都会有巨大数量的图片产生,以往传统的人工处理方式再也无法匹配高速增长的数据量。而在当代计算机科学飞速发展的背景下,计算机可以帮助人类从繁琐的运算中解放,而且在许多的应用环境中计算机能够表现得比人类更为优秀。在这种背景下,人工智能(AI)这一极富挑战性的科学应运而生,其下分支机器学习中的深度学习更是在图像分类中大放异彩。

首先来谈人工智能(AI)技术。在一百多年前的第二次工业革命后,“电气时代”到来,社会的电气化为每一个主要行业的发展注入新鲜的动力,当下的AI技术则是最新的电力[1]。虽然目前的人工智能技术与“终结者”相差甚远,但它给现代社会带来的巨大转变是肉眼可见的,这种令人感慨的能量将在未来的十年中创造出一个惊人的世界与社会。我们这些IT行业的探索者能在创建AI社会的过程发挥重要作用。

在AI的各个分支中,深度学习的发展最为迅速,通常把训练神经网络(一般是大规模神经网络)模型的过程用深度学习这一术语来表达。而“神经网络”这一看似非常高端的术语仅仅是名字就击退了一部分同学,一旦深入了解后就会发现它不过是个空壳子。神经网络需要做的,仅仅是对于给定的输入x给出相关的映射输出y,相关研究人员所研究的也可总结为如何更快、更准、更方便地给出这个y。现在,深度学习是科技世界中广受欢迎的一种技巧。

多亏了深度学习的发展,计算机视觉在以往几年中也取得了长足的进步,卷积神经网络(CNN)是其中的代表作品。我们可以输入一个图像,用训练好的CNN模型来给它贴上标签就可以投入到相应的使用。仅仅一个图像分类技术问世,人类就从繁琐的手工区分图像中解放,之后的人工智能技术给人类带来的便捷真是激动人心。

在当代机器学习、深度学习、计算机科学大发展的时代背景下,深度学习可谓是前程无量,深入地剖析其内部算法并将其投入到实际的应用场景可谓是意义非凡。然后遗憾的是,由于没有基础理论的支撑,“神经网络”这一名词让许多同学心生畏惧,身边多数的同学都认为这是一门“忽悠”人的学科,对我抱以怀疑的态度。

在时代与实际的双重背景下,我开始了这门课题。

1.2 国内外研究现状

1998年,CNN传统网络模型提出,名为LeNet。受限于硬件,LeNet结构未能广泛应用,但其给出了卷积网络的基本结构定义:卷积+池化+全连接。

2012年,深度学习史上有里程碑意义的网络模型:AlexNet被提出。该模型有8层,分别为卷积1层(池化1层)、卷积2层(池化2层)、卷积3层、卷积4层、卷积5层(池化5层)、全连接6层、全连接7层、输出8层。此外,还用更好的ReLU函数、dropout正则化方法避免出现过拟合,LRN加速训练,GPU加速。

2013年ZF-Net获得ImageNet分类任务冠军,仅在AlexNet基础上调参,总体性能却有了很大的提升。之后的VGG模型在2014年提出,简单来看,该模型就是“加深”后的AlexNet。

2015年,何恺明提出深度残余网络(ResNet)。他在网络模型的结构上进行改变,不再是以往简单的函数堆积过程,因解决了深层模型存在的梯度弥散问题,在深度学习发展史上这一模型的提出有里程碑意义。2017年的DenseNet是一种密集链接的网络,其吸收ResNet精华部分,并作出创新,使得网络性能进一步提升[2]。

当下,诸多著名大型公司都在第一时间内成立聚焦于深度学习技术的人工智能(AI)研究院或者研究机构,以将人类从枯燥的劳动中解放。

1.3 论文主要研究安排

本文既从卷积神经网络的内部原理进行剖析,完成其具体的数学理论公式推导过程,又从应用层面着手搭建属于自己风格的卷积神经网络,进行不同方式的图像测试。主要研究内容包括以下几个方面:

1. 研究最为基本的全连接神经网络,介绍起始点逻辑回归的Sigmoid函数、损失函数和梯度下降;然后提出全连接神经网络的激活函数、Softmax损失函数、神经网络的正向传播及反向传播。

2.研究深度学习的优化方法和几种实用的机器学习策略,包括为何奏效的合理解释。

3.研究卷积神经网络,介绍其基础理念包括卷积层(含Padding填充、卷积步长等)、池化层与全连接层等。在卷积神经网络的正向传播和反向传播推导之后介绍几种较为经典的CNN网络模型,并且论述本文选择指定模型的原因。

4.在指定工具上进行项目的实施,介绍了所用的工具特点,研究图像测试的结果,并且研究卷积神经网络的迁移学习使用情况。

1.4 论文章节结构安排

本文以卷积神经网络为重点,介绍其前身基本人工神经网络的基础理论,又介绍了数种深度学习的优化方法和机器学习的策略,在最后具体实施卷积神经网络。论文结构的安排如下:

第一章讲述课题的背景意义、研究现状及论文的安排。

第二章介绍神经网络,从理论入手,推导逻辑回归的梯度下降法和全连接神经网络的正向传播及反向传播,在最后通过java语言实现自己设计的模型。

第三章介绍了几种神经网络的优化算法和机器学习实际项目实施时候的策略以提升网络模型的质量并且减少项目实施中所耗费的资源。

第四章研究卷积神经网络,并且选定本文要实现的网络模型并阐述理由。

第五章进行项目的实施,讲解了所使用的工具的特点。搭建网络后进行图像分类效果的测试。之后实施卷积神经网络的迁移学习,将网络模型微调以适用于自身准备的数据集,观察微调训练过程中损失值及精确度的变化过程。

结尾处作出本文的总结与展望等。

总结与展望

本文从卷积神经网络的数学层面着手研究,在拥有理论支撑后开始项目实施。之后介绍了几种深层网络的优化方法以及机器学习项目实施的策略,从理论角度论述其奏效原理。最后进行项目的实施,包括网络的搭建、模型的测试以及迁移学习的应用,通过比较后发现微调后的模型更加适用于自己准备的数据。

项目能够成功运行之后内心十分开心,然而本次课题实施过程并非一帆风顺,从选题阶段开始便伴随诸多烦恼。首先要面临的,是对未知的恐惧。由于本科期间几乎没有相关课程,本次课题不得不从零开始。学习基础概念的过程像是在艰难地跋涉,坚持下来的动力是一句忠告:走出舒适圈。我本可以在自己的“圈子”里“增删查改”,但收获的成长将微乎其微。在学习完基础理论后,我又发现代码的实施才是最大的难点。虽然网上有大段现有的,但是找到适合自己的、能够运行得起来的代码绝非一件易事。在花费了巨大的精力调通代码后,我的心态也改变了。现在的心理可谓是“无所畏惧”,这是本次课题最大的收获。

项目实施过程中,印象非常深刻的有两个关键点。一个是在加载bvlc_alexnet.npy文件时报“维度不匹配”的错误,回想学习理论课程时,吴恩达教授介绍AlexNet模型采用双GPU同时运行加速训练,检查了参数文件维度后发现这一点,调参后解决了困扰我几天的难题。第二个是在迁移学习的训练过程,无论进行多少轮的训练,损失与精度都没有具体的改善。在把整个代码的运行逻辑疏通了一遍后,我找出原先代码的思维漏洞,改写后成功解决问题。

再谈当前的深度学习技术,所谓的“人工智能”都是为特定任务制定的。以现代飞速爆炸式增长的数据量来看,深度学习还无法满足人们的各类需求,更不用提未来赋予机器“智能”。究其原因,远远不止是技术本身问题,而是人类各个领域的基础理论都不支持,比如硬件资源直接制约深度学习的发展。当下应该有正确的综合指导思想,让机器学习的发展少走弯路。

当一种技术承载着人类未来的希望,它就应该成为一种信仰,让全人类为止奋斗。

参考文献:

[1]李德毅,刘常昱,杜鹢,韩旭.不确定性人工智能[J].软件学报,2004(11):4-5.

[2]周飞燕,金林鹏,董军.卷积神经网络研究综述[J]. 计算机学报,2017(06):15-18.

[3]李航.统计学习方法[M].清华大学出版社,2012.

[4]王海良,陈可心,思珍.智能问答与深度学习[M].北京:电子工业出版社,2019.

[5]刘力银.基于逻辑回归的推荐技术研究及应用[D].电子科技大学,2013.

[6]房靖晶,成金勇.基于改进的Faster R-CNN的目标检测与识别[J] .图像与信号处理 , 2019:8-9.

[7]Jinhao Du,Tao Yang,Xue Chen,Jia Chai,Yan Zhao,Sheping Shi.A CNN-based cost-effective modulation format identification scheme by low-bandwidth direct detecting and low rate sampling for elastic optical networks[J].Optics Communications,2020:156-160.

[8]刘建伟,刘媛,罗雄麟.深度学习研究进展[J].计算机应用研究,2014(07):8.

[10]付文博,孙涛,梁藉,闫宝伟,范福新.深度学习原理及应用综述[J].计算机科学,2018:2-5.

[11]卢宏涛,张秦川.深度卷积神经网络在计算机视觉中的应用研究综述[J].数据采集 与处理,2016(01):5-12.

[12]黄奥云,程宾洋,孙家炜.基于卷积内部进化机制与特征融合的人脸识别算法的研究 [J].现代计算机(专业版),2019(10):75-80.

[13]陈旭,张军,陈文伟,李硕豪.卷积网络深度学习算法与实例[J].广东工业大学学, 2017(06):5-6.

[14]李志义,许洪凯,段斌.基于深度学习CNN模型的图像情感特征抽取研究[J].图书情报工作,2019(11):8-10.

[15]Anil Kumar,C.P. Gandhi,Yuqing Zhou,Rajesh Kumar,Jiawei Xiang.Improved deep convolution neural network (CNN) for the identification of defects in the centrifugal pump using acoustic images[J].Applied Acoustics,2020.

[16]魏秀参.解析深度学习 卷积神经网络原理与视觉实践[M]. 北京:电子工业出版社,2018.11.

[17]刘鹏.深度学习[M].北京:电子工业出版社,2018.01.

[18]王秉睿,兰慧盈,陈云霁.深度学习编程框架[J].大数据,2018(04):3-7.

[19]胡学龙.数字图像处理 第3版[M]. 北京:电子工业出版社,2014.08.

[20]曼普里特·辛格·古特,(印)拉蒂普·杜瓦.TensorFlow神经网络编程程[M].北京机械工业出版社,2018.11.

[21]陈仲铭,彭凌西.人民邮电 深度学习原理与实践[M].北京:人民邮电出版社,2018.08.

[22]龙明盛.迁移学习问题与方法研究[D].清华大学,2014.

[23]Salman Ul Hassan Dar,Muzaffer Özbey,Ahmet Burak Çatlı,Tolga Çukur.A Transfer‐Learning Approach for Accelerated MRI Using Deep Neural Networks[J].Magnetic Resonance in Medicine,2020:663-685.

[24]刘建伟,赵会丹,罗雄,麟许鋆.深度学习批归一化及其相关算法研究进展[J].自动化学报,2019:10-15.

[25]Jinsong Zhu,Chi Zhang,Haidong Qi,Ziyue Lu.Vision-based defects detection for bridges using transfer learning and convolutional neural networks[J].Journal of Medical and Biological Engineering,2020:1037-1049

[26]余宸希.基于Alexnet神经网络的物体识别研究[J].电子制作,2019(12).